首页 > Betway必威手机版中心 > 正文

来源: 发布:2021-01-29 阅读量:

(通讯员 赵秀臣)近期,必威BETWAY官网吕锡香教授指导的博士生李一戈的论文「Neural Attention Distillation: Erasing Backdoor Triggers from Deep Neural Networks」,被人工智能顶级会议ICLR 2021收录,在ICLR 2021会议近3000篇投稿中,均分排名前7.5%。这项研究成果由西电必威BETWAY官网、蚂蚁集团、迪肯大学、墨尔本大学和UIUC合作完成。

ICLR(International Conference on Learning Representations),即国际学习表征会议,成立于2013年,由深度学习三大巨头之二的Yoshua Bengio和Yann LeCun共同牵头创办,发展至今已经被学术研究者们广泛认可,被誉为“深度学习的顶级会议”,目前在H5-index领域已超越ICML、NeurIPS等,在所有顶会中影响力仅次于CVPR。

本篇论文的研究对象是AI安全领域的后门攻击。作为一种发生在训练阶段的定向攻击,后门攻击近年来在AI安全中引起了极大的重视。后门攻击能够控制模型的预测结果,但是却不会影响正常样本的预测准确率,是一种相当隐蔽且危险的攻击。更重要的是,一旦将后门触发器嵌入到目标模型中,就很难通过传统的微调或神经修剪来彻底消除其恶意的影响。

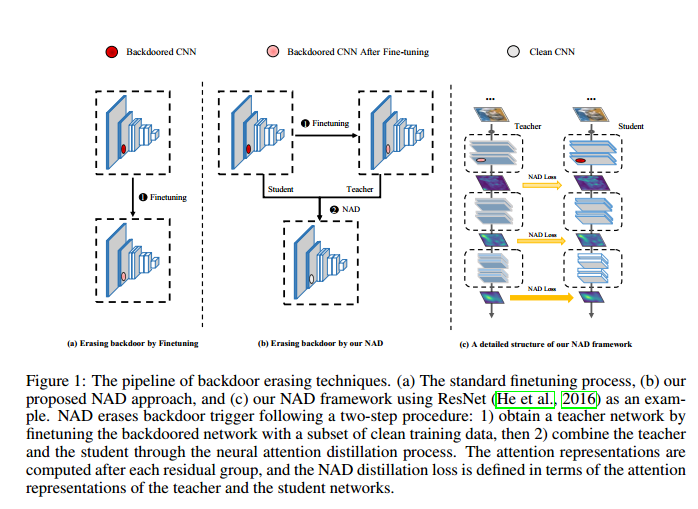

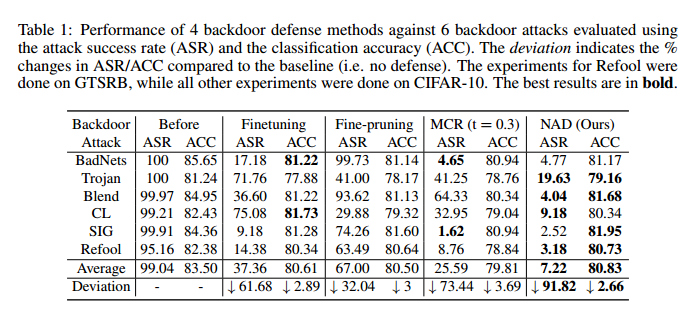

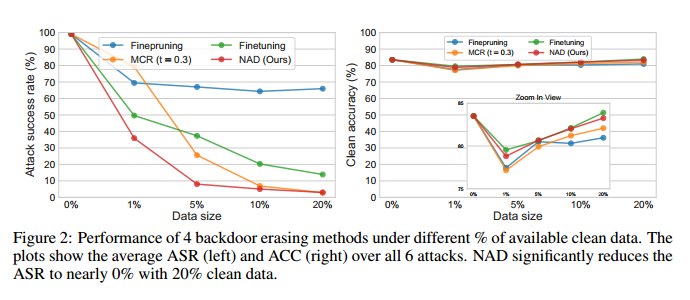

针对这一问题,本文提出了一种新颖的防御框架--神经元注意力蒸馏(Neural Attention Distillation,NAD),以消除DNN中的后门触发器。NAD利用教师网络在少量干净的数据子集上指导后门员工网络的微调,以使员工网络的中间层注意力激活与教师网络的注意力激活保持一致。其中,教师网络可以通过对同一干净子集进行独立的微调获得。针对6种最新的后门攻击——BadNets,Trojan attack,Blend attack,Clean-label attack,Sinusoidal signal attack,Reflection attack,验证了提出的NAD的有效性,仅使用5%的干净训练数据就可以有效擦除后门触发器,同时几乎不影响干净样本的性能。

本文提出的基于神经元注意力蒸馏的后门净化方法是目前业界最简单有效的方法,能够抵御目前已知的所有后门攻击,理论分析表明该方法具有对后门攻击的普适性防御能力。论文代码已经开源:https://github.com/bboylyg/NAD。

本论文指导老师吕锡香教授认为,该研究产出的神经元注意力蒸馏后门攻击防御框架,提供了目前SOTA的通用后门防御技术,防御效果最好,防御范围最大,普适性最好,防御方法简单,通用于工业界任何需要使用外部预训练模型的应用场景。相信该技术的创新将为深度学习安全研究提供重要借鉴意义,在未来将有望应用于各行业,进行精准行业赋能,对深度模型的在产业界的应用落地提供重要安全保障。